Meta anunció que identificará a las imágenes creadas con Inteligencia Artificial

Nick Clegg, el responsable de asuntos internacionales de la compañía, admitió que la medida "no eliminará" totalmente el riesgo de producción de imágenes falsas, pero "minimizará" su proliferación.

Meta, el gigante de las redes sociales, anunció que "en los próximos meses" comenzará a identificar cualquier imagen generada por Inteligencia Artificial (IA) que aparezca en alguna de sus plataformas como Facebook, Instagram, Threads.

La compañía ya identifica las imágenes generadas con la ayuda de su propia herramienta, “Meta IA”, que fue lanzada en diciembre, pero el representante de Meta indicó que quieren "hacer lo mismo con contenidos creados con herramientas de otras empresas" como Google, OpenAI, Microsoft, Adobe, Midjourney o Shutterstock.

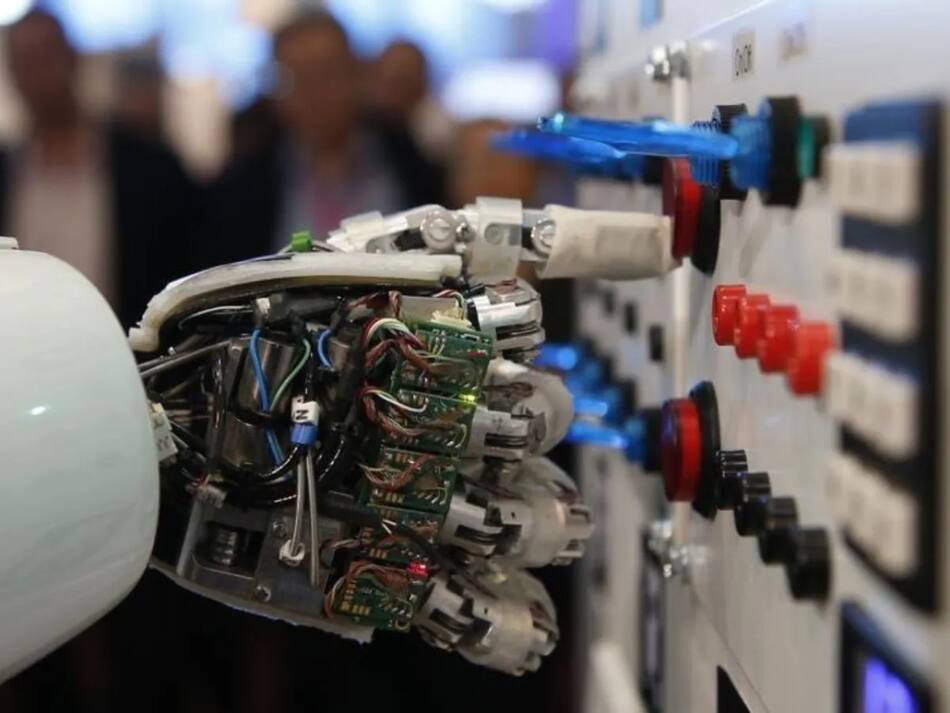

Inteligencia Artificial. Foto: Reuters.

"Estamos construyendo esta herramienta en estos momentos, y en los próximos meses comenzaremos a aplicar etiquetas en todos los idiomas compatibles con cada aplicación", remarcó Nick Clegg, el responsable de asuntos internacionales de Meta.

También podría interesarte

A su vez Clegg admite que este etiquetado "no eliminará" totalmente el riesgo de producción de imágenes falsas, pero "ciertamente minimizará" su proliferación "dentro de los límites de lo que la tecnología permite actualmente".

Los problemas de las imágenes creadas por IA

El auge de la Inteligencia Artificial generativa suscita temores de que las personas utilicen estas herramientas para crear un caos político, principalmente a través de la desinformación y casi la mitad del mundo tendrá elecciones este año.

Inteligencia Artificial, tecnología. Foto: Reuters

Sumado a esto, el desarrollo de programas de IA generativa podría producir un flujo incontrolable de contenidos degradantes, como las imágenes falsas ("deepfakes") con contenido explícito de mujeres famosas.

Un ejemplo de esto fue una imagen falsa de la cantante estadounidense Taylor Swift que fue vista 47 millones de veces en la red social X a finales de enero antes de ser eliminada, y según medios estadounidenses, la publicación permaneció en línea en la plataforma durante aproximadamente 17 horas.

La empresa californiana creadora de ChatGPT, OpenAI, también había anunciado a mediados de enero el lanzamiento de herramientas para combatir la desinformación, y marcó su voluntad de no permitir el uso de sus herramientas tecnológicas con fines políticos.