Elon Musk y gobiernos advierten peligros de la inteligencia artificial y buscan limitarla

Ante la difusión de noticias falsas y mensajes discriminatorios, distintas entidades buscan legislar el desarrollo de esta tecnología para disminuir los riesgos.

Elon Musk. Foto: Reuters.

El desarrollo de la inteligencia artificial para la creación de textos, imágenes y otro tipo de formatos obtuvo varias críticas en el último tiempo. Se cuestiona desde distintas instituciones la posibilidad de recibir información falsa o dañina. Por este motivo, algunos organismos gubernamentales y empresarios buscan regular el desarrollo de esta tecnología.

En este sentido, Elon Musk firmó una carta junto a un grupo de profesionales de la tecnología y empresarios donde solicitan suspender el entrenamiento de modelos más potentes que el ChatGPT-4 recientemente lanzado por OpenAI. Allí advierten sobre los peligros de la inteligencia artificial (IA) para la humanidad.

Inteligencia Artificial. Foto: Telam.

La ONG Future of Life Institute lanzó la carta abierta signada por más de 1.000 personas, donde piden pausar el entrenamiento de esta tecnología avanzada hasta que se generen y ejecuten protocolos de seguridad compartidos para tales diseños donde expertos independientes auditen los procesos. "Los potentes sistemas de IA solo deben desarrollarse cuando estemos seguros de que sus efectos serán positivos y sus riesgos controlables", asegura la carta.

El comunicado aparece luego de que Europol, la policía de la Unión Europea, se uniera a diversas entidades que expresan preocupaciones éticas y legales sobre la IA avanzada como ChatGPT. Además, advierten sobre el uso indebido de estos sistemas que puede generar desinformación y ciberdelincuencia. Por otra parte, Sam Altman, el CEO de OpenAI, se negó a firmar la carta.

La Comisión Europea busca regular la Inteligencia Artificial

La inteligencia artificial no está exenta de generar imágenes con contenido pornográfico, o falsificación de datos ya que actúa en base a un gran almacenamiento de datos que recorren absolutamente toda la internet, y sin embargo no los chequea. En este sentido, Sam Altman, que creó los modelos lingüísticos generativos ChatGPT, planteó la necesidad de limitar de alguna manera estas tecnologías.

Sam Altman, CEO de OpenAI. Foto: Reuters.

“Necesitamos tiempo suficiente para que nuestras instituciones decidan qué hacer. La regulación será crítica y llevará tiempo resolverla”, escribió el empresario en su perfil oficial de Twitter. La Comisión Europea trabaja en este sentido desde 2021, año en que planteó una propuesta restrictiva para este tipo de software.

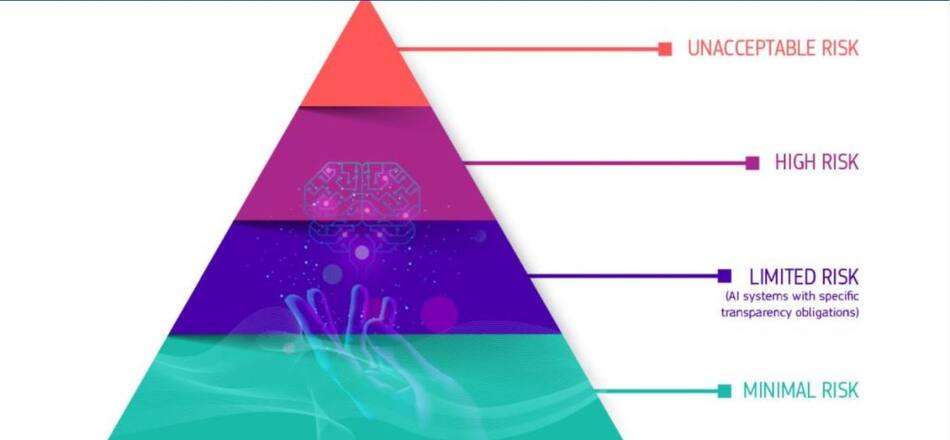

Según este organismo, hay una necesidad de regular esta tecnología para “evitar resultados no deseados”. El objetivo es mejorar el servicio de inteligencia artificial, reduciendo las posibilidades de daño. La Comisión intenta establecer una “pirámide de riesgos” que sitúa a los peores riesgos en la parte superior. Con la ilustración de esta pirámide, las inteligencias que se adecúen a alguna de las categorías deberán cumplir ciertos requisitos antes de ser lanzadas al mercado.

Pirámide de riesgos para inteligencia artificial. Foto: Comisión Europea.

Las calificadas como de “Alto Riesgo” implican obligaciones tales como la implementación de altos niveles de seguridad para los consumidores, la supervisión humana para evitar peligros, además de dar información clara y adecuada. También está el requisito de incrementar la base de datos de los sistemas con instrumentos de alta calidad para evitar mensajes de odio. También plantean que será necesario monitorear la actividad de los usuarios guardando un registro por necesidad.

Por otra parte, Janet Haven, la directora de Data & Society de Estados Unidos, planteó: “necesitamos regular esto, necesitamos leyes (...)”. “La idea de que las compañías de tecnología puedan construir lo que quieran y liberarlo al mercado mientras que la sociedad lucha para acostumbrarse y utilizarla es hacer las cosas al revés”, expresó la ejecutiva.

ChatGPT. Foto: Reuters

Sin embargo, el CEO de OpenAI, declaró que pueden haber otras maneras de regularlo que no impliquen una legislación. El empresario dijo que la misma inteligencia artificial puede correjirse a sí misma para reducir el margen de peligro. "Debemos tener cuidado y al mismo tiempo entender que no sirve tenerlo todo en un laboratorio. Es un producto que debemos difundir y que haga contacto con la realidad y tener errores mientras los riesgos son bajos. Habiendo dicho eso, creo que la gente debería estar feliz de que estemos algo asustados de esto. Si pudiera decir que no me asusta, no deberías confiar en mi (...)”, aseguró Altman en dialogo con ABC News.