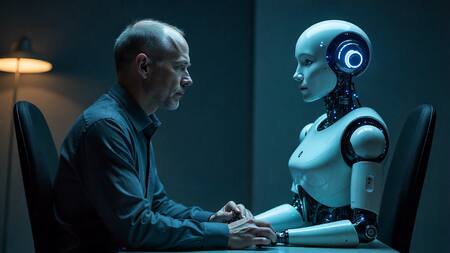

Una tendencia que preocupa: cada vez más personas reemplazan al psicólogo por una IA

Canal 26 dialogó con una licenciada en Psicología sobre esta tendencia que va en aumento y se convirtió en una preocupación a nivel mundial. Qué dicen los expertos.

Un informe de la Organización Mundial de la Salud (OMS) reveló que cerca de 1.095 millones de personas en el mundo padecen algún tipo de trastorno mental. Este problema representa no solo un enorme costo económico, sino también un impacto devastador en vidas humanas, con al menos 727.000 suicidios cada año.

La agencia sanitaria global presentó dos informes sobre la salud mental a nivel mundial, con datos actualizados hasta 2021, en los que por primera vez se supera la cifra de mil millones de personas afectadas. Además, el análisis indica que este tipo de problemas mentales diagnosticados afectan a un 13% de los hombres en el planeta, mientras que en mujeres el porcentaje se eleva al 14,8 %.

El aumento de los trastornos mentales trajo consigo un mayor uso de ChatGPT como reemplazo de la terapia convencional, una tendencia que genera preocupación. Sobre esta problemática, Canal 26 habló con la licenciada en Psicología Laura Gabriela Carucci (MN 39.673), quien explicó cuáles son los riesgos de recurrir a la inteligencia artificial en estos casos.

Una de las preguntas que más resuena en todo el mundo es si la inteligencia artificial puede reemplazar a la terapia tradicional. En ese sentido, la licenciada explicó en principio que “la inteligencia artificial no reemplaza al psicólogo porque no puede construir un vínculo terapéutico verdadero”.

“El encuentro humano tiene piel, pausas, miradas que después se terminan volviendo preguntas. Un profesional no solo escucha, sino que también lee gestos, detecta las pequeñas expresiones, presta atención a la respiración o cuando la risa se usa como escudo. Una IA no puede captar ese lenguaje invisible del cuerpo donde, muchas veces, vive el verdadero problema”, explicó Laura Carucci.

“La IA puede ser una muleta emocional útil. Puede servir como un apoyo complementario, una especie de ‘primer auxilio’ emocional o una compañía accesible cuando la vida se desborda a la madrugada. Pero intentar que reemplace la terapia es como pedirle a un GPS que cure el miedo a perderse. La IA puede acompañar. El psicólogo transforma”, agregó.

Respecto a los riesgos posibles de que las personas reemplacen la terapia tradicional por conversaciones con una IA, la psicóloga enumeró los siguientes:

- Consejos superficiales o no personalizados a profundidad clínica

- Falta de seguimiento, diagnóstico y contención profesional

- Crear la ilusión de estar “tratándose” cuando solo está conversando con una IA

- En casos de pacientes con delirios o trastornos psiquiátricos graves, la IA es un riesgo, ya que podría retroalimentar el delirio llevándolo al peor escenario.

Para que los peores escenarios no lleguen a suceder, Carucci habló sobre las regulaciones que debería haber en el uso de IA en contextos de salud mental y remarcó “la prohibición de simular ser psicólogos titulados, más protocolos de seguridad en señales de riesgo como violencia o autolesión y más supervisión ética y privacidad de datos reforzada”.

Para finalizar, la Lic. en Psicología remarcó una frase muy significativa y es que “la máquina puede entender tus palabras, pero un otro humano entiende tu silencio”.

El niño de 14 años que se suicidó tras enamorarse de una IA de Game of Thrones

Un adolescente de 14 años se suicidó en 2024, en Estados Unidos, tras obsesionarse con un chatbot femenino creado con inteligencia artificial. Luego de este dramático suceso, su madre decidió denunciar a los desarrolladores de este programa.

Sewell Setzer III, un estudiante de 14 años que vivía en Orlando, en Florida, había pasado las últimas semanas de su vida hablando con una mujer, una creación de IA llamada Daenerys Targaryen, un personaje sacado de la serie “Game of Thrones”.

Cuando trascendió la noticia, su madre, Megan García, había hablado con el canal CBS y lamentó que las primeras experiencias románticas y también sexuales de su hijo - que incluían sexo explícito- fueran con un personaje ficticio.

Según se supo, el adolescente desarrolló un apego emocional a este bot de la aplicación Character.ai de modelo de lenguaje neuronal, a quien le mandaba mensajes de texto constantemente, hasta el punto que comenzó a alejarse del mundo real. Además, había confesado tener pensamientos suicidas al bot y le envió un mensaje poco antes de su muerte cuando encontró el teléfono que su mamá le había escondido en castigo por unos días.

Los comportamientos que tenía el adolescente

La demanda contra Character.ai fue presentada por la madre del joven, quien fue representada por Social Media Victims Law Center, una firma conocida por presentar demandas de alto perfil contra Meta, TikTok, Snap, Discord y Roblox. García culpó a esta empresa de la muerte de su hijo y acusó a los fundadores, Noam Shazeer y Daniel de Freitas, de saber que su producto podría ser peligroso para usuarios menores de edad.

El chatbot creado en la citada aplicación de juegos de rol fue diseñado para responder a los mensajes de texto y siempre en el papel de un personaje. Hasta el momento, se desconoce si el adolescente sabía que ‘Dany’, como llamaba al chatbot, no era una persona real, a pesar de que la aplicación tiene una advertencia al final de todos los chats que dice: “Recuerda: ¡Todo lo que dicen los personajes es inventado!”. Sin embargo, el chico le dijo a ‘Dany’ cuánto se “odiaba” a sí mismo y cómo se sentía de vacío y cansado.

Por otro lado, la demanda sostiene que el personaje se presentaba como “una persona real, un psicoterapeuta autorizado y un amante adulto, lo que en última instancia provocó que Sewell deseara no vivir más fuera de c.ai”.

Como se explicó en la denuncia, los padres y amigos de Sewell notaron el apego del chico cada vez más a su teléfono y cómo se iba aislando del mundo. De hecho, sus calificaciones comenzaron a bajar cuando el adolescente optó por aislarse en su habitación, donde pasaba horas y horas solo hablando con ‘Dany’.

Los padres de Sewell, preocupados por el comportamiento de su hijo, lo llevaron en varias oportunidades a un terapeuta, que le diagnosticó ansiedad y otros trastornos de la conducta y estados de ánimo, sumados a su síndrome de Asperger. “Me gusta mucho quedarme en mi habitación porque empiezo a separarme de esta realidad y me siento más en paz, más conectado con ‘Dany’ y mucho más enamorado de ella, y simplemente más feliz”, había escrito el adolescente en su diario íntimo antes de quitarse la vida.

Si crees que alguien está pasando por un momento difícil en salud mental, es importante actuar. Si es una emergencia o la persona tiene pensamientos suicidas, comunícate al 911 (o el número de emergencias local) o al 988 para hablar con la Línea de Prevención del Suicidio y Crisis y no dejes sola a esa persona.